近年、AI技術の急速な発展により、ChatGPTをはじめとする対話型AIが私たちの生活のさまざまな場面に浸透してきています。特に注目すべきは、メンタルヘルスの分野におけるAIの活用です。実際、多くの人がChatGPTに悩みを相談したり、心の内を打ち明けたりする現象が見られるようになりました。このような状況に対して、「AIが精神科医やカウンセラーの代わりになれるのか」「AIに相談することの意味とは何か」といった疑問が浮かび上がってきます。

従来、心の悩みは家族や友人、あるいは専門家に相談するものでした。しかし、人間関係の希薄化や専門家へのアクセスの難しさから、気軽に利用できるAIが新たな「相談相手」として注目されています。実際にChatGPTは、睡眠や食事、運動といった生活習慣の改善から、ワークライフバランスの見直しまで、多角的な視点からアドバイスを提供することができます。

しかし、AIが精神医療の専門家に取って代わることができるのか、また、AIによるメンタルサポートにはどのような利点と限界があるのかについては、慎重な検討が必要です。この記事では、ChatGPTと精神科の関係性について、さまざまな側面から考察していきます。

ChatGPTは精神科医の代わりになれるのか?

ChatGPTは精神科医の代わりになれるのでしょうか?結論から言えば、現時点では完全に代替することはできません。その理由はいくつかあります。

まず、ChatGPTには医師としての専門的な訓練や臨床経験がありません。精神科医は長年の医学教育と臨床実習を通じて診断や治療に必要な知識と技術を身につけています。特に精神疾患の診断には、症状の詳細な観察、表情や声のトーンの変化、非言語的なコミュニケーションの把握など、人間特有の感覚が重要になります。ChatGPTはテキストベースのコミュニケーションに限られるため、これらの要素を完全に捉えることができません。

次に、精神科医は薬物療法を含む医療行為を行う権限を持っています。うつ病や統合失調症などの精神疾患では、適切な薬物療法が症状の改善に不可欠なケースが多くあります。ChatGPTは医療行為を行うことはできず、薬の処方や調整はできません。例えば、躁うつ病の患者には気分安定薬が必要ですが、その薬の種類や用量は患者の状態に応じて慎重に調整する必要があります。

さらに、ChatGPTにはリアルタイムの危機介入能力が限られています。自殺リスクの高い患者や急性精神症状を呈している場合には、迅速かつ適切な介入が求められますが、ChatGPTではこうした緊急対応が難しいのが現状です。

一方で、ChatGPTが精神医療の分野で補助的な役割を果たす可能性は高いと言えます。例えば、医療機関へのアクセスが難しい地域や、精神科医が不足している状況では、初期の相談窓口やスクリーニングツールとして活用できるかもしれません。また、軽度のストレスや不安に対するセルフケアの提案、生活習慣の改善アドバイスなど、予防的な健康支援においては一定の効果が期待できます。

ただし、どんなに優れたAIであっても、人間同士の深い共感や信頼関係に基づく治療的関係を完全に再現することは難しいでしょう。精神医療の本質は、単なる情報提供や症状への対処だけでなく、患者と医師の間に築かれる治療的関係性にあるからです。ChatGPTは精神科医の代わりにはなれませんが、メンタルヘルスケアの新たな選択肢として、その役割を模索していくことが重要です。

メンタルヘルスの相談にChatGPTを利用する際の利点と注意点とは?

ChatGPTをメンタルヘルスの相談に利用する場合、いくつかの明確な利点があります。まず、アクセスの容易さが挙げられます。ChatGPTは24時間いつでも利用可能で、経済的な負担も少なく、地理的な制約もありません。特に地方在住者や多忙な人々にとって、このアクセスのしやすさは大きなメリットと言えるでしょう。

また、ChatGPTは匿名性が高いため、人に話しづらい悩みや恥ずかしいと感じる問題も打ち明けやすい環境を提供します。社会的なスティグマへの恐れから専門家への相談をためらう人々にとって、この匿名性は心理的安全性をもたらします。実際に、「人からどう思われるだろう」という不安を感じることなく、自分の悩みを整理できる場として機能することがあります。

さらに、ChatGPTの応答は判断や批判を含まないニュートラルな特性を持っています。これにより、利用者は自己開示への抵抗感が低減され、自分の感情や考えを率直に表現しやすくなります。特に初期段階の自己認識や問題の整理において、このような環境は有益です。

しかし、ChatGPTをメンタルヘルスの相談に利用する際には、いくつかの重要な注意点も存在します。最も重要なのは、ChatGPTは専門的な診断や治療を提供できないという限界です。深刻な症状がある場合や、専門的な介入が必要な状況では、適切な医療機関や専門家に相談することが不可欠です。特にうつ病や不安障害などの精神疾患が疑われる場合は、早期に専門家の診断を受けることが重要です。

また、ChatGPTはデータに基づいて応答するため、個人の具体的な状況や文化的背景を完全に理解することが難しいという限界もあります。このため、アドバイスが一般的になりがちで、個人の特殊な状況に完全に適合しない可能性があります。例えば、特定の文化における家族関係の複雑さや、地域特有の社会的プレッシャーなどの文脈を十分に考慮できない場合があります。

さらに、ChatGPTは意識していない心理的問題を指摘したり、言語化されていない感情を読み取ったりする能力には限界があります。熟練したカウンセラーであれば、クライアントの言葉や態度から、表面上は表現されていない問題を感知することがありますが、ChatGPTにはそのような直感的な理解力は備わっていません。

そして、過度の依存リスクも考慮すべき点です。ChatGPTへの相談が、実際の人間関係や専門家との関わりを避ける理由になってしまう可能性があります。健全なメンタルヘルスには、実際の社会的つながりや支援ネットワークが欠かせないことを忘れてはなりません。

したがって、ChatGPTはメンタルヘルスのサポートツールとして活用する際には、その利点を生かしつつ限界を理解し、必要に応じて専門家のサポートを求めるという賢明なアプローチが求められます。

精神科医から見たChatGPTの評価はどうなっているのか?

精神科医からのChatGPTに対する評価は多様で、肯定的な見解と批判的な見解の両方が存在します。まず肯定的な評価として、ChatGPTがメンタルヘルスの入口としての役割を果たす可能性が挙げられています。専門家へのアクセスが難しい人々にとって、初期的な相談窓口となり得るという点は一定の評価を受けています。

また、ChatGPTが職業病的なバイアスを持たない点も興味深い特徴として注目されています。ある精神科医は、「ChatGPTは自分が精神科医であるという自覚を持っていないため、『人を見たら病気だと思う』職業病に罹患していない」と指摘しています。このため、いきなり病気と見なすことをせず、睡眠習慣、食事・運動、業務内容、職場環境、ワークライフバランスなど、複数の可能性を考慮したアドバイスを提供できるという点が評価されています。

一方で、批判的な見解も少なくありません。多くの精神科医は、ChatGPTによる応答が「おざなり」で「表面的」なものに留まると指摘しています。精神科医の春日武彦氏はインタビューで、ChatGPTの応答について「理詰めで考えられる答えを網羅したカタログのような応答」と評し、人間らしい共感や理解が欠けていると指摘しています。

さらに重要な点として、人が悩みを相談する際に本当に期待しているのは、単なる回答ではなく、「まじめに話を聞いてもらった」「ちゃんと人として扱ってもらえた」「共感してもらえた」という経験であることが多いという指摘があります。春日氏は「相手が尊敬できる先輩なら、『お前そんなことで悩んでいたのか、馬鹿だな』と言ってもらっただけでスッキリしてしまうこともある」と述べ、人間同士の関係性の中で生まれる治療的な要素をAIが完全に再現することは難しいという認識を示しています。

また、臨床現場の専門家からは、ChatGPTが認知行動療法や問題解決療法などの特定の心理療法のフレームワークを応用できる可能性がある一方で、深層心理へのアプローチや無意識の領域へのアクセスには根本的な限界があるという指摘もあります。精神分析的アプローチや対人関係療法など、治療者と患者の関係性に重きを置く治療法では、AIによる代替は困難であるという見方が強いです。

総じて、多くの精神科医はChatGPTを完全な代替手段としてではなく、補完的なツールとして位置づける見方が主流です。特に予防的なメンタルヘルスケアや、軽度の問題に対する初期サポート、そして専門家へのアクセスが難しい状況での橋渡し的な役割において、その可能性が認められています。ただし、重度の精神疾患や複雑なトラウマを抱える患者への対応においては、依然として訓練された専門家の介入が不可欠であるという点で意見が一致しています。

ChatGPTとカウンセリングの違いは何か?

ChatGPTと専門的なカウンセリングには、いくつかの根本的な違いがあります。まず最も重要な違いとして、カウンセリングが人間同士の関係性に基づくプロセスであるのに対し、ChatGPTとのやり取りはアルゴリズムによる応答という点が挙げられます。

専門的なカウンセリングでは、資格を持ったカウンセラーが対面または遠隔で継続的な関係性を構築します。このプロセスでは、治療的関係(ラポール)の形成が非常に重要であり、信頼と安全の感覚がセラピーの効果を高める基盤となります。カウンセラーは言語的・非言語的なコミュニケーションを通じて、クライアントの反応を細かく観察し、感情的なニュアンスや微妙な変化を感知することができます。

一方、ChatGPTとのやり取りはテキストベースに限定されており、感情の機微や非言語的な要素を捉えることができません。また、ChatGPTには一貫した記憶や真の理解力がなく、表面的なパターン認識に基づいて応答を生成しているに過ぎません。このため、深い共感や真の理解を伴う関係性の構築は本質的に不可能です。

次に、専門的なカウンセリングは特定の理論的枠組みと方法論に基づいています。認知行動療法、精神力動的アプローチ、人間中心療法など、さまざまな心理療法のアプローチがあり、各アプローチには独自の理論と技法があります。訓練されたカウンセラーはこれらの方法論を理解し、クライアントの状況や目標に合わせて適切に適用することができます。

ChatGPTは特定の心理療法の原則を模倣することはできますが、その適用は表面的であり、クライアントの個別の状況に応じた柔軟で創造的な適応が難しいという限界があります。また、カウンセリングプロセスで重要な「治療計画」の策定や進捗の評価など、長期的な視点での介入設計も困難です。

さらに、専門的なカウンセリングには倫理的・法的な枠組みが存在します。カウンセラーは守秘義務、インフォームドコンセント、クライアントの自律性の尊重など、明確な倫理規範に従う義務があります。また、危機介入が必要な状況(自殺のリスクなど)では、適切な対応をとる責任があります。

ChatGPTにはこのような倫理的責任の概念がなく、倫理的ジレンマに直面した際の判断も一貫性を欠くことがあります。また、危機的状況の評価や適切な紹介プロセスの実施も困難です。

加えて、カウンセリングには「無意識へのアクセス」という側面もあります。熟練したカウンセラーは、クライアントが明示的に表現していない問題や、自覚していない感情パターンを感知し、それを適切に治療プロセスに組み込むことができます。例えば、クライアントが表面的には仕事のストレスについて話していても、その背後にある幼少期からの承認欲求や自己価値に関する無意識の信念を探索することがあります。

ChatGPTには、このような深層心理へのアプローチや無意識の領域へのアクセスは本質的に不可能です。ChatGPTは「自覚している」悩みにしか対応できず、クライアント自身が認識していない心理的課題や、言語化されていない感情を読み取ることができません。

以上のように、ChatGPTとカウンセリングには本質的な違いがあり、ChatGPTがカウンセリングの代替になることは難しいと言えます。しかし、アクセスの容易さや初期段階での情報提供など、補完的な役割としての可能性は十分にあると考えられます。

AIと精神医療の未来はどのように進化していくのか?

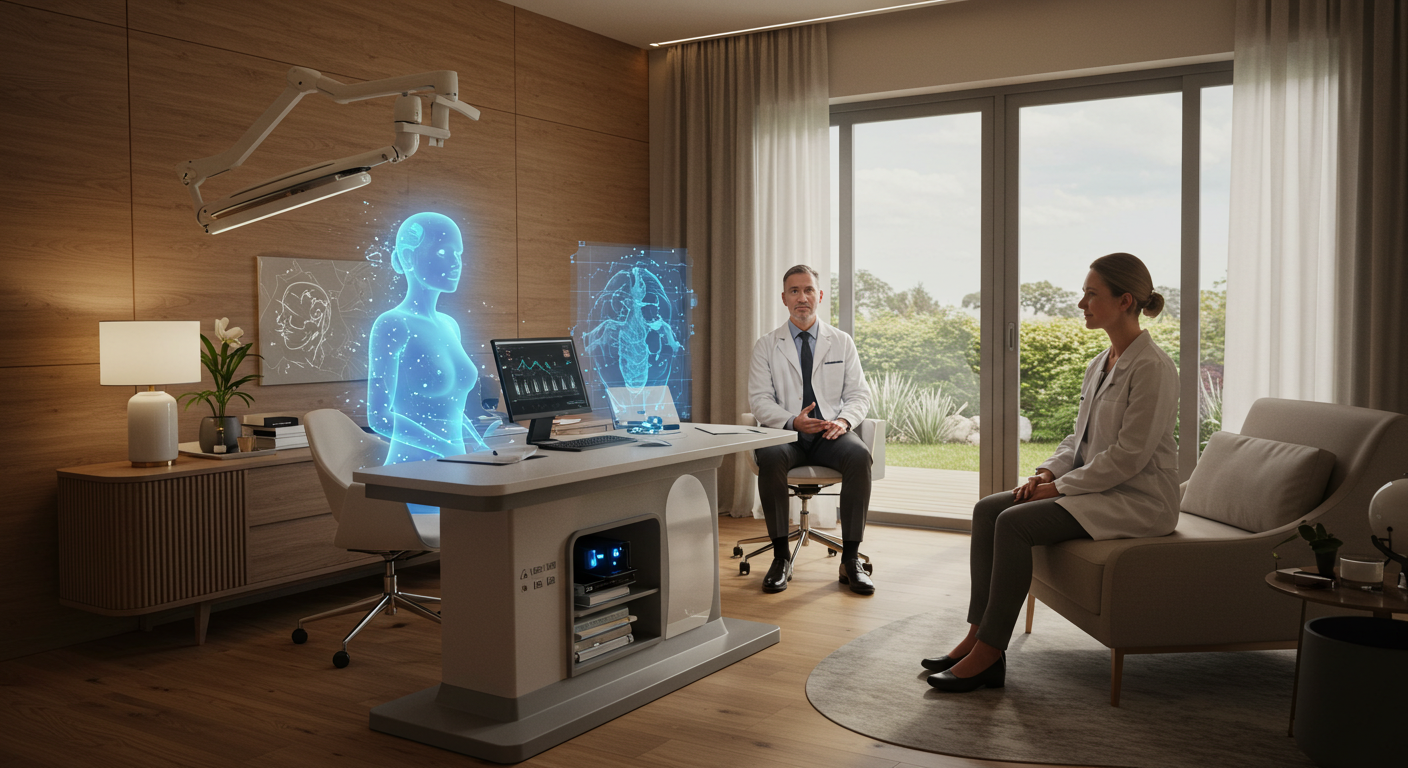

AIと精神医療の関係は今後、協働的かつ補完的な方向へと進化していくことが予想されます。両者が完全に独立するのではなく、また一方が他方を完全に代替するのでもなく、それぞれの強みを活かした新たなハイブリッドモデルが発展していく可能性が高いでしょう。

まず、AIが精神医療の「入口」としての役割を担うようになると考えられます。現在でも多くの人がメンタルヘルスの悩みをChatGPTに相談していますが、この傾向は今後も続くでしょう。特に初期段階でのスクリーニングや、軽度の症状に対するセルフケアのガイダンスにおいて、AIの活用が進むと予想されます。例えば、うつ症状や不安症状の初期段階で、AIが標準化された質問を通じて評価を行い、必要に応じて専門家への紹介を提案するシステムが一般化するかもしれません。

次に、AIが臨床医の意思決定支援ツールとして活用される可能性があります。膨大な医学論文や臨床データを分析し、診断や治療方針の決定をサポートするAIシステムの開発が進むでしょう。例えば、患者の症状パターン、生活習慣データ、遺伝的要因などを総合的に分析し、最適な治療法を提案するAIアシスタントが臨床現場で活用される可能性があります。

また、デジタルセラピーとAIの融合も進むと考えられます。認知行動療法などの構造化された心理療法をベースにしたデジタルインターベンションと、パーソナライズされたAIコーチングを組み合わせたアプローチが発展するでしょう。例えば、不安障害の治療において、エクスポージャー(苦手な状況への段階的な曝露)を支援するVRシステムとAIコーチを組み合わせたプログラムなどが考えられます。

さらに、リアルタイムモニタリングとケアの継続性が向上する可能性があります。ウェアラブルデバイスやスマートフォンのセンサーから得られるデータをAIが分析し、気分の変動や行動パターンの変化を検出することで、早期介入やリラプスの予防に役立てることができるでしょう。例えば、双極性障害の患者の睡眠パターンや活動量の変化をモニタリングし、気分エピソードの前兆を検出するシステムなどが実用化される可能性があります。

医療資源の格差解消にも貢献することが期待されます。精神科医やカウンセラーの不足している地域でも、AIを活用したリモート診療支援により、質の高いメンタルヘルスケアへのアクセスが向上する可能性があります。例えば、遠隔地の医師がAIの支援を受けながら診療を行うモデルや、コミュニティヘルスワーカーがAIツールを活用して基本的なメンタルヘルスケアを提供するアプローチなどが考えられます。

ただし、こうした発展には重要な課題も存在します。プライバシーやデータセキュリティの問題、AIの判断に関する透明性と説明可能性、そして誤った診断や提案によるリスクなど、多くの倫理的・法的課題を解決していく必要があります。また、AIが人間の専門家との関係を完全に代替することは望ましくないという認識も重要です。

最終的には、AIは精神医療において「ツール」としての役割を担い、人間の専門家の能力を拡張し、医療の質とアクセスを向上させるための手段として活用されるべきでしょう。人間特有の共感や複雑な関係性の理解、文化的・社会的文脈の把握といった能力は依然として人間の専門家の強みであり、これらとAIの強みを組み合わせることで、より包括的で効果的なメンタルヘルスケアシステムが構築されることが理想的な未来像と言えるでしょう。

コメント